Всем привет. В этой статье вы узнаете, как закрыть сайт от индексации поисковыми системами: Яндекс, Google и другими. А также, как прятать отдельные разделы.

При создании нового web-ресурса на первое время его желательно скрыть от поисковиков.

Дело в том, что поисковики уже при первом обходе вашего нового сайта должны правильно определить его тематику. Это очень важно для дальнейшего правильного развития.

Поэтому сначала нужно написать минимум 5 статей строго по выбранной тематике, а уже только потом открывать его для индексации.

Кстати правильно определиться с тематикой будущего интернет-ресурса — это очень важный этап. От этого зависит ваш будущий заработок и не только.

Как закрыть сайт от индексации

Мне известно 2 способа:

- Средствами cms WordPress

- С помощью специального метатега.

Если у вас другая система, то у нее скорей всего тоже есть подобные встроенные средства

Статья: Как выбрать CMS движок для сайта

Считается, что второй способ надёжнее: первый — поисковики могут проигнорировать. Это не точно, но лучше не рисковать.

Поэтому используйте сразу два способа для надёжности, чтобы наверняка.

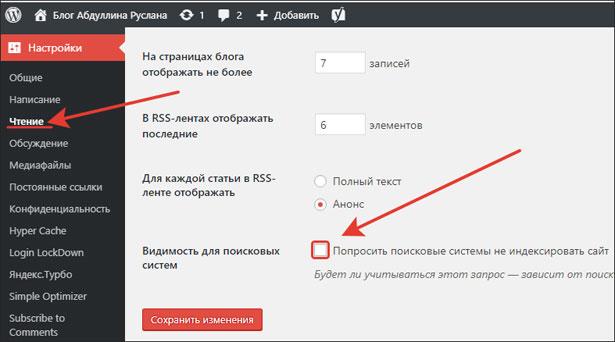

Средствами CMS Вордпресс

Инструкция:

- Зайдите в админ панель Вордпресс;

- Перейдите в настройки чтения;

- Попросите поисковые системы не индексировать сайт;

- Сохраните изменения.

Meta name robots

Необходимо в код своего сайта внутри секции head добавить следующий код:

<meta name="robots" content="none"/>

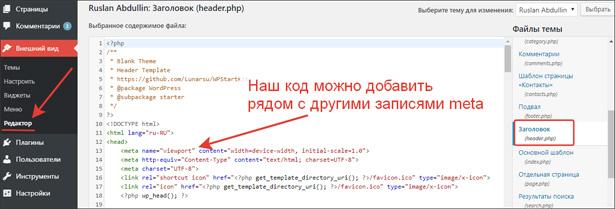

Если ваш ресурс на вордпрессе, то вам нужен файл Заголовок (header.php).

Как найти Header.php

Вообще есть 3 способа:

- В редакторе вордпресса

- В менеджере файлов на сервере (хостинге)

- Через FTP менеджер

Если это для вас сложно, то найдите специалиста (прогера, верстальщика).

А на самом деле это просто. Покажу подробно первый способ:

- В админ панели WordPress перейти во «Внешний вид» → «Редактор»

- Справа найти Заголовок (header.php)

- Вставить наш код между открывающим и закрывающим тегом HEAD

Через хостинг и FTP менеджер делается аналогично. Кстати на блоге есть статья-инструкция по ФТП менеджеру Falezilla. Рекомендую ознакомиться.

Как закрыть от индексации отдельные страницы

У открытого для поисковиков сайта не все страницы должны быть открыты для поисковиков. Некоторые разделы нужно закрыть от индексации.

Как правило, от индексации скрывают следующее:

- Страницы пагинации

- всевозможные дубли

- файлы темы

- Другое

Необходимо также скрывать те разделы, которые попадают в поиск, но их там быть не должно

В поиске должен находиться только полезный для посетителей контент.

Способы реализации:

- Файл robots.txt

- Meta name robots

- Rel canonical

Как правило, эти три способа используются параллельно.

Robots.txt

На своем блоге я уже рассказывал вам, как создать robots txt. В нем можно задать рекомендации и для яндекса, и для гугла: что индексировать (allow), а что нет (disallow).

Таким образом скрывают от индексации целые разделы сайта (которые представляют из себя мусор для поиска или дубли).

Meta name robots

С помощью следующего кода можно скрывать отдельные страницы, например, пагинации:

<meta name ="robots" content ="noindex, follow"/>.

- Noindex даёт указание поисковикам не индексировать

- Follow разрешает переходить по ссылкам. Лучше не запрещать ходить по ссылкам, роботы должны хорошо понимать структуру интернет-ресурса.

Но добавить этот код в header.php уже не получится, т.к. этот код должен быть только у отдельных страниц. Сделать это получится либо с помощью спец плагинов, либо верстальщиков.

Плагин SEO by Yoast отлично справляется с этой задачей.

Атрибут Rel=canonical

А теперь поговорим про атрибут Rel canonical.

Страницы бывают канонические и неканонические. Канонические — это главные исходные, которые должны быть в поиске. А неканонические — это дубли, контент которых почти такой же, как у главной.

Такое часто встречается в интернет магазинах. Например, в каталоге представлены товары. Для поиска товаров используется множество фильтров.

Когда пользователь пользуется фильтром, получается как бы новая страница. Но она не должна попасть в поиск. Она должна весь свой вес, поведенческие факторы передавать на каноническую исходную.

Атрибут rel = canonical позволяют сказать поисковикам, что эта ссылка является дублем, её не нужно добавлять в поиск, а весь её вес, все поведенческие факторы должны давать плюс в карму канонической. Формат записи следующий:

<link rel="canonical" href="http://site.ru/glavnaya-str" />

Прописывается на страницах-дублях с указанием главной канонической. Но как это сделать самому, я не знаю. Можно воспользоваться специальными плагинами. Тот же SEO by yoast расставляет эти атрибуты автоматически, например, когда статья находится одновременно в двух рубриках.

Лайфхак. Очень удобно проверять индексируется ли УРЛ с помощью расширения Seo Meta in oneclick

Если страница по-прежнему в индексе

Бывает случается так. Вы сделали всё от вас зависящее, а некоторые ссылки-дубли по-прежнему находятся в индексе Яндекса и/или Гугла.

В этом случае удалите ее вручную в панели вебмастера яндекса и гугла соотвестственно.

Вот ссылки:

- Для Яндекса - https://webmaster.yandex.ru/tools/del-url/

- Для Гугла - https://search.google.com/search-console/removals

Таким образом нельзя удалить любую ссылку. А только те, которые запрещены к индексации или не существуют.

Заключение

В этой статье мы с вами разобрались, как закрыть сайт от индексации. Рассмотрели несколько рабочих способов. Уверен, теперь у вас всё получится.

А также я рассказал, как скрывать отдельные разделы и страницы, которые вообще не нужно отправлять в индекс поисковиков.

Кстати чтобы ваш web-ресурс проиндексировали быстрее после открытия, нужно, как минимум:

- Добавить сайт в панель вебмастера Яндекса и Google Search Console

- Внедрить счетчик яндекс.метрики

- Используйте «Переобход страниц» в Яндексе и «Попросить проиндексировать» в Google Search Console.

Помогла ли вам моя статья? Жду ваших комментариев.

Всем пока и до скорых встреч.

С уважением, Абдуллин Руслан

В поиске должен находиться только полезный для посетителей контент.

В поиске должен находиться только полезный для посетителей контент.