Всем привет. В этой статье вы узнаете, как создать robots txt для сайта. Этот файл говорит поисковикам, что внутри вашего web-ресурса нельзя индексировать, а что можно.

Если же вам необходимо закрыть весь сайт от индексации, то лучше воспользуйтесь этой инструкцией.

У меня блог на Вордпрессе. Я покажу вам, как этот файл выглядит у меня. Если вы используете другую CMS, то будет примерно также по аналогии, только названия разделов будут отличаться.

Robots txt — что это и зачем нужен

Представьте себе, что ваш web-site — это коробка. Вы складываете в эту коробку различные вещи, документы.

У роботов Яндекса и Гугла работа заключается в том, что они:

- открывают эти коробки,

- изучают, что в них находится,

- рассказывают всем

Но мы не хотим, чтобы все жители интернета знали абсолютно обо всех вещах, которые лежат в коробке. Возможно, там лежат наши секреты, какой-нибудь старый мусор или просто никому не интересная информация.

Чтобы робот не изучал эту лишнюю информацию, надо сказать ему об этом. Вот теперь-то на сцену и выходит файл robots.txt. Он выступает в роли наклейки на коробке. На ней написано, что трогать не нужно и о чем нельзя всем рассказывать. В результате, робот не станет тратить свои ресурсы на изучение запретных разделов.

Robots.txt — это обычный текстовый файл с инструкциями для роботов.

Как сделать правильный robots txt

Чтобы робот понял нас, мы должны говорить с ним на одном языке.

Нам потребуются следующие наиболее часто используемые команды (директивы):

- User-agent — для обращения к конкретному роботу (* — ко всем, Yandex — к яндексу);

- Allow — разрешить индексирование указанного раздела;

- Disallow — запретить;

- Host — указывает на главное зеркало;

- Sitemap — указывает на место хранения карты сайта.

Есть и другие команды, но в большинстве случаев используются только эти.

Инструкция по созданию роботс txt

- Создать обычный текстовый документ в блокноте с расширением .txt и назовите его robots.

- Наполните нужными командами.

- Загрузите в корневую папку сайта.

Важно: использовать кириллицу запрещено,

и размер файла не должен превышать 32 кБ

Как загрузить файл в корневую папку

Используйте один из следующих способов:

- Программа ftp менеджер FileZilla

- Файловый менеджер на хостинге

- Редактор в админке вашей CMS (у меня вордпрес)

Лично мне больше нравится первый способ.

Анализ моего роботса

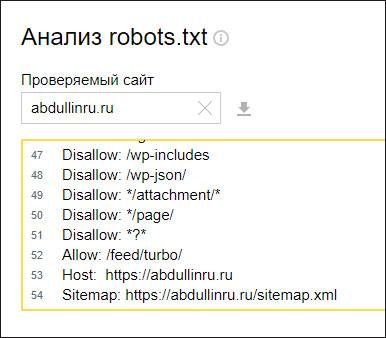

Проще всего объяснить используемые директивы на конкретном примере. По адресу abdullinru.ru/robots.txt вы можете ознакомиться с тем, какими командами наполнен этот файл у меня.

Он довольно длинный, но сложного ничего нет. Сейчас разберемся во всем по порядку.

Во-первых, я дважды использую директиву User-agent. Это позволяет дать разные указания яндексу и гуглу.

Если посмотреть внимательно, то команды Disallow для гугла и яндекса идентичны. То есть обоим поисковикам я запрещаю доступ к одним и тем же разделам сайта. Это в общем-то логично.

Но вот команды Allow уже отличаются. Яндексу я разрешаю доступ к разделу /feed/turbo/ — это нужно для функционирования турбо страниц. А гуглу я дал доступ к множеству файлов темы своего сайта: стилям, скриптам, картинкам. Это одно из его требований для корректного понимания моего интернет-ресурса.

В директиве Host указывается главное зеркало: https://abdullinru.ru

В директиве Sitemap указывается путь к карте сайта.

Если разложить всё по полочкам, то становится не так уж и сложно

Как проверить правильность команд

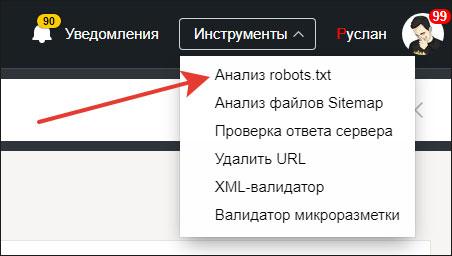

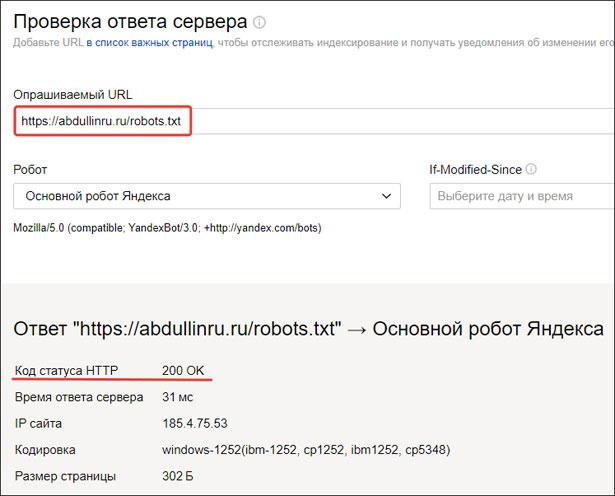

После создания текстового документа и наполнения всеми командами, его нужно проверить. Для этого перейдите в панель вебмастеров Яндекса.

Если вы еще не добавили свой веб-ресурс, то пришло время. Сделайте это прямо сейчас. Вот инструкция.

В инструментах вебмастера выберите «анализ robots.txt»

На загруженной странице в соответствующих полях укажите свой домен и содержимое файла. Нажмите «проверить».

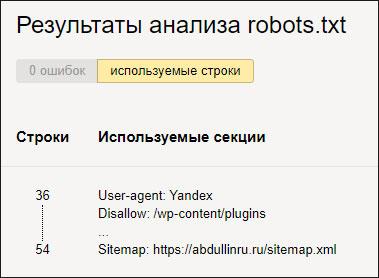

Далее вы увидите результат проверки. Если есть ошибки, вы их увидите и сможете исправить.

Еще ниже есть поле, в котором вы можете проверить, насколько правильно вы дали указание поисковикам. Например, давайте проверим, будет ли Яндекс индексировать разделы /feed/turbo/ и просто feed.

Как видите, результат правильный: feed — не индексируется, а /feed/turbo/ — индексируется.

Важно. Обязательно проверьте, доступен ли Robots в корне вашего сайта. Для этого выберите инструмент «проверка ответа сервера». Введите адрес vash-domen.ru/robots.txt. В итоге код ответа сервера должен быть 200.

Заключение

Изучив эту статью, вы узнали, как создать robots txt для сайта. А также я рассказал вам на наглядном примере, для чего он нужен и какую функцию выполняет.

Теперь вы знаете больше о том, как правильно настроить индексирование своего web-ресурса.

Надеюсь, что моя статья помогла вам решить свою проблему. Если остались вопросы, пишите комментарии. Я обязательно отвечу.

Подписывайтесь на обновления моего блога, впереди еще много важных публикаций на тему раскрутки и продвижения сайтов и не только.

Всем пока и до скорых встреч.

С уважением, Абдуллин Руслан